lftp的sftp使用时遇到的坑

今天在使用lftp的sftp时候一直处于connecting状态,并且没有其他提示信息。状态如下图所示:

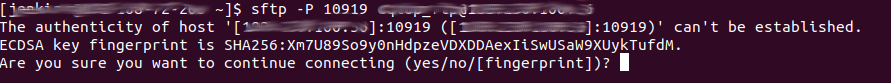

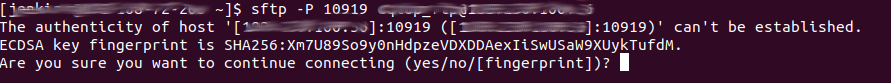

导致这个问题的原因是,在sftp第一次连接服务器的时候需要接收服务端服务器的fingerprint,这个过程需要用户通过输入进行确认,如下图所示。但是这些提示信息被lftp掩盖了,所以connecting状态其实是sftp一直在等待用户的输入。解决方法是先在命令行使用sftp连接一次服务器,然后再使用lftp。

今天在使用lftp的sftp时候一直处于connecting状态,并且没有其他提示信息。状态如下图所示:

导致这个问题的原因是,在sftp第一次连接服务器的时候需要接收服务端服务器的fingerprint,这个过程需要用户通过输入进行确认,如下图所示。但是这些提示信息被lftp掩盖了,所以connecting状态其实是sftp一直在等待用户的输入。解决方法是先在命令行使用sftp连接一次服务器,然后再使用lftp。

在MR处理ORC的时候遇到如下异常:

1 | Exception in thread "main" java.lang.ArrayIndexOutOfBoundsException: 1024 |

通过搜索发现这个Bug在Hive 2.1.1版本中已经修复。我使用的就是这个版本,检查对应的源代码发现代码是已经按照下面的Patch修复过得:https://issues.apache.org/jira/browse/HIVE-14483

Nginx是不支持POST请求静态内容的,通过POST请求时出现以下错误:

1 | # curl -d "a=b" "http://192.16.36.15:11013/upgrade" |

解决方法是在Nginx配置中添加以下配置:

源码下载参考我的另外一片博文:CentOS 7.3 编译 Rsyslog 8.1903.0。

本篇博文从创建构建环境开始填坑/(ㄒoㄒ)/~~。通过上一篇博文可以解决的问题此处不再赘述。

执行配置时出现以下错误:

源码下载:

1 | # wget https://github.com/rsyslog/rsyslog/archive/v8.1903.0.tar.gz |

创建构建环境:

使用Rsyslog的omhttp模块可以将收集的日志数据以HTTP请求的方式输出。该模块支持单条/批量发送数据,支持GZIP压缩,支持HTTPS。

Rsyslog默认未包含omhttp模块,需要重新编译。编译过程参考我的另外两篇博文:

导出示例:

1 | $ mongoexport --host 192.168.72.60 --db realtime_statistic_backup --collection all_play_stats_summary --fields "_id.timestamp,total_uv" --type csv --out uv.csv --sort "{'_id.timestamp': -1}" --query "{'_id.province_id':'sc','_id.city_id':'all', '_id.display_name': 'all'}" |

--uri方式连接MongoDB--fields指定要导出的field,如果是嵌套的json,可以通过点(.)操作指定内层的field在使用Jenkins编译Hadoop3.1.2时报错信息如下:

1 | [INFO] --- hadoop-maven-plugins:3.1.2:protoc (compile-protoc) @ hadoop-common --- |

原因是Jenkins中找不到protoc命令。解决方法是在Jenkins中配置环境变量PATH指定protoc路径。

使用以下命令安装指定版本的包:

1 | # pip install pyspark==2.3.3 |